初乐营销SEO专员

在网站的SEO优化过程中,robots.txt文件是一个重要的工具。它可以帮助网站管理员控制搜索引擎爬虫的访问,并影响搜索引擎对网站内容的索引。本文将深入探讨robots.txt文件的写法及其在百度SEO和Google SEO中的作用。

Robots.txt文件的基本结构

robots.txt文件是一个文本文件,位于网站的根目录下。其基本结构包括两个主要部分:User-agent和Disallow。

1. User-agent

User-agent指定了对应规则适用的搜索引擎爬虫。例如,对Googlebot的规则将以User-agent: Googlebot开头。

2. Disallow

Disallow规定了指定搜索引擎爬虫在访问网站时需要遵循的限制。通常,使用Disallow: /表示不允许爬虫访问整个网站,而Disallow: /example/表示不允许访问特定目录。

Robots.txt文件的写法

1. 基本写法

一个简单的robots.txt文件可能如下所示:

User-agent: *

Disallow: /private/

这表示允许所有爬虫访问网站,但不允许它们访问/private/目录。

2. 多User-agent写法

可以为不同的搜索引擎指定不同的规则。例如:

User-agent: Googlebot

Disallow: /private/

User-agent: Bingbot

Disallow: /restricted/

这表示Googlebot不允许访问/private/目录,而Bingbot不允许访问/restricted/目录。

Robots.txt文件的作用

1. 节省带宽和资源

通过设置robots.txt,网站可以防止搜索引擎爬虫访问不必要的页面,从而减少带宽和资源的消耗。

2. 控制搜索引擎索引

通过禁止搜索引擎爬虫访问特定目录或页面,网站管理员可以更精确地控制哪些内容被索引,哪些内容被忽略。

3. 保护敏感信息

对于包含敏感信息的目录,可以使用robots.txt来限制搜索引擎对其内容的访问,提高网站的安全性。

注意事项

robots.txt文件不是强制性的,搜索引擎爬虫可以选择遵守或忽略其中的规则。敏感信息不应该仅仅依赖于

robots.txt来保护,其他安全措施也应该同时考虑。

如何查看网站的Robots.txt文件?

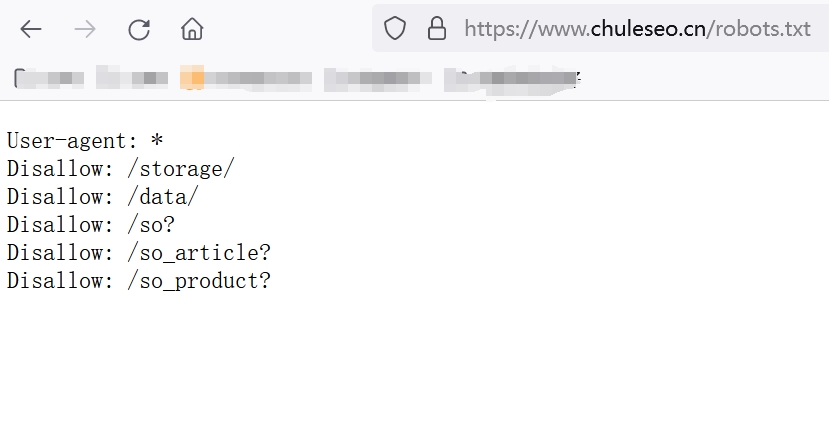

访问一个网站,然后在其域名下增加/robots.txt,就可以看到对应的文件了,比如:初乐网络科技有限公司,你可以在域名/www.chuleseo.cn/增加robots.txt即可访问,https://www.chuleseo.cn/robots.txt

如何查看网站的Robots.txt文件?

如何检查重要页面是否被robots.txt文件屏蔽?

你可以添加百度站长资源权限或者Google search console,然后在百度站长资源平台找到网址诊断即可检测robots.txt协议是否正确?如果是Google ,你可以直接将网址复制到Google search console管理后台就可以看到网站诊断的结果。

结论

robots.txt文件是网站SEO中一个简单而有效的工具。通过巧妙配置,网站管理员可以更好地控制搜索引擎爬虫的行为,提高网站在搜索结果中的表现。在百度SEO和Google SEO中,正确使用robots.txt文件可以为网站带来更好的排名和更精准的搜索引擎索引。

下一篇: 如何优化网站SEO关键词排名?

豫公网安备 50010702500968号

豫公网安备 50010702500968号